L’intelligence artificielle ou informatique cognitive a été et reste un sujet infini pour le cinéma ! Dans le monde réel, elle se manifeste de plus en plus fréquemment et certains secteurs professionnels l’utilisent déjà avec succès. Quel avenir dans les prochaines années ?

Qu’est-ce que l’informatique cognitive et quelle est actuellement son utilisation concrète ?

Pour la plupart d’entre nous, la simple idée d’un ordinateur qui pense par lui-même est effrayante en soi ; il ne faut donc pas s’étonner d’être bombardés d’intrigues cinématographiques et d’histoires sur l’intelligence artificielle qui envahit le monde. Par conséquent, toute enquête qui tente d’aborder l’impact potentiel de l’informatique cognitive doit tenir compte des idées fausses et de l’estompement des limites entre la singularité et un moteur d’analyse de données sophistiqué. La plupart des gens ont un avis sur l’IA, même s’ils n’en comprennent pas vraiment le sens ; ce qui a une incidence sur l’idée générale qu’on se fait de l’informatique cognitive.

Alors que des sommités telles que Elon Musk se concentrent sur l’IA et la futurologie - Musk a récemment annoncé qu’il développait un produit visant à faire de nous tous des super-héros - dans un avenir prévisible, le rôle que jouera l’informatique cognitive dans la vie de tous les jours sera plus banal, mais en fin de compte extrêmement utile. En permettant à un ordinateur construit avec des algorithmes d’auto-apprentissage (Machine Learning) d’« apprendre » à partir de grandes quantités de données, d’identifier des modèles et de suggérer des actions possibles, l’informatique cognitive a le potentiel de résoudre des problèmes extrêmement complexes.

Conçu par IBM, Watson fait partie des ordinateurs cognitifs les plus connus. Il a fait sa première apparition publique dans le jeu télévisé américain Jeopardy ! en 2011, gagnant le premier prix de 1 million USD face à deux champions légendaires. Aujourd’hui, le superordinateur Watson aide à prédire la météo et à améliorer les soins de santé, y compris la découverte de nouveaux médicaments.

C’est un domaine qui se développe rapidement, notamment avec les centres de recherche spécialisés dans les machines « pensantes » comme Google DeepMind, CognitiveScale et Cognitive Services de Microsoft, pour n’en citer que quelques-uns. Étant donné la quantité de données générées dans quasiment tous les secteurs de l’industrie – 2,5 quintillions d’octets de données sont créés chaque jour à notre rythme actuel – nous aurons besoin d’ordinateurs cognitifs pour leur donner du sens. Sinon, quel est l’intérêt ?

Quel sera l’impact de cette technologie sur le monde du travail dans cinq ans ?

Comme on pouvait s’y attendre, un tiers des personnes interrogées croient que l’informatique cognitive aura le plus grand impact de toutes les tendances technologiques sur leur entreprise au cours des cinq prochaines années. Cette hypothèse est logique étant donné l’essor rapide de l’autoapprentissage et la prolifération des données transmises par les dispositifs et les réseaux IdO. Cependant, son impact ne sera pas facile à déterminer car dans la majorité des cas il risque d’être à la fois positif et négatif.

L’idée persiste qu’avec l’apparition de machines plus intelligentes l’automatisation supprimera des emplois. Une récente étude de l’OCDE révèle que 47 % des emplois aux États-Unis et 35 % des emplois au Royaume-Uni seraient « touchés » et il n’est donc pas surprenant que les gens considèrent la technologie cognitive comme une menace. Mais elle offre également de nouveaux débouchés propices à la création d’emplois. Combinée aux données IdO, par exemple, l’informatique cognitive a le potentiel de générer des connaissances sur tout, depuis l’analyse de trafic jusqu’aux erreurs de conception dans les éoliennes, et de suggérer des solutions. Pour de nombreuses personnes, l’informatique cognitive ne facilitera pas seulement leur travail, elle le rendra plus dynamique et innovant, quel que soit le secteur d’activité.

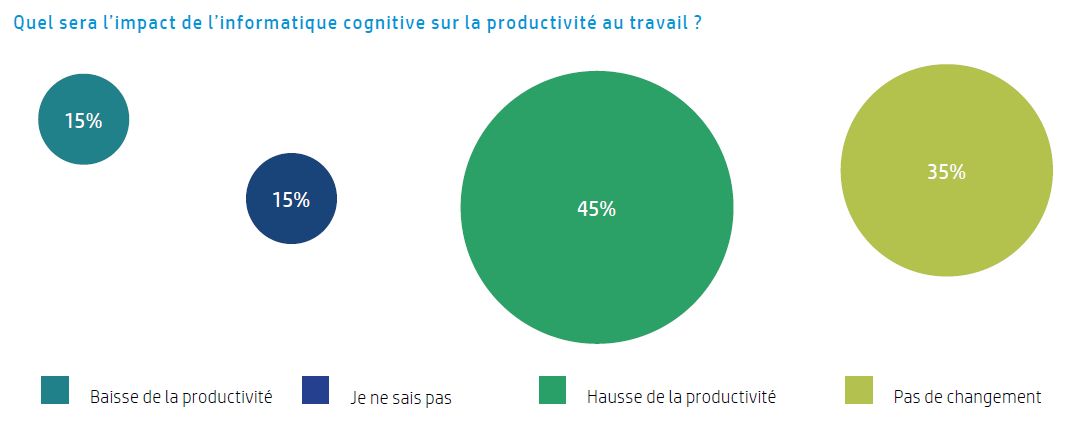

Gagnerons-nous en productivité avec l’informatique cognitive ?

En ce qui concerne la productivité, les réponses fournies sont sans équivoque. 45 % des personnes interrogées croient qu’elle augmentera la productivité, mais bien entendu sous certaines réserves. Pour commencer, l’informatique cognitive rendra superflues les tâches administratives les plus courantes. Pour la plupart, il ne s’agit pas d’une fonction principale. Les entreprises s’intéresseront à la technologie cognitive pour résoudre des problèmes complexes et accroître la compétitivité par l’innovation, renforcer la sécurité ou améliorer la personnalisation des produits et services. Une grande partie du travail viendra s’ajouter aux emplois existants ou créera de nouveaux emplois au-delà des pratiques traditionnelles.

Les personnes interrogées qui travaillent dans de grandes entreprises sont même plus enclines à croire que la productivité sera stimulée (51 %). Et ce pourcentage est encore plus élevé dans les grandes entreprises françaises (59%). Considéré à l’échelle des données, cela a du sens. Plus de données équivaut à une plus grande probabilité d’obtenir des analyses plus précises et d’agir de façon mieux informée. Un hypermarché, par exemple, pourrait mieux cerner les besoins des clients dans une ville qu’une petite supérette. C’est une question d’échelle.

Évidemment, la façon dont les entreprises utiliseront les données et les renseignements en découlant variera et l’interprétation humaine déterminera sans aucun doute l’utilité ou le succès de l’analyse cognitive. Cela signifie-t-il que les employés seront plus productifs ou que globalement les entreprises gagneront en productivité, agilité et efficacité ? Cela prendra du temps, c’est sûr. Comme le suggère un quart des personnes interrogées, il est probable qu’il n’y ait pas de changement dans la productivité au cours des cinq prochaines années et, dans l’ensemble, elles ont peut-être raison. La question des compétences est certainement à considérer dans ce cas. Il faudra du temps pour apprendre de nouveaux systèmes et pour les employés et les services de créer et gérer de nouveaux processus.

Ainsi, d’une certaine façon, la productivité pourrait diminuer avant de remonter, du moins d’ici cinq ans. Certains services vont presque certainement être confrontés au changement plus tôt. La recherche médicale, notamment, est un domaine où les gains en productivité sont toujours les bienvenus et celle-ci, du moins pour le moment, semble faire l’objet d’une attention particulière.

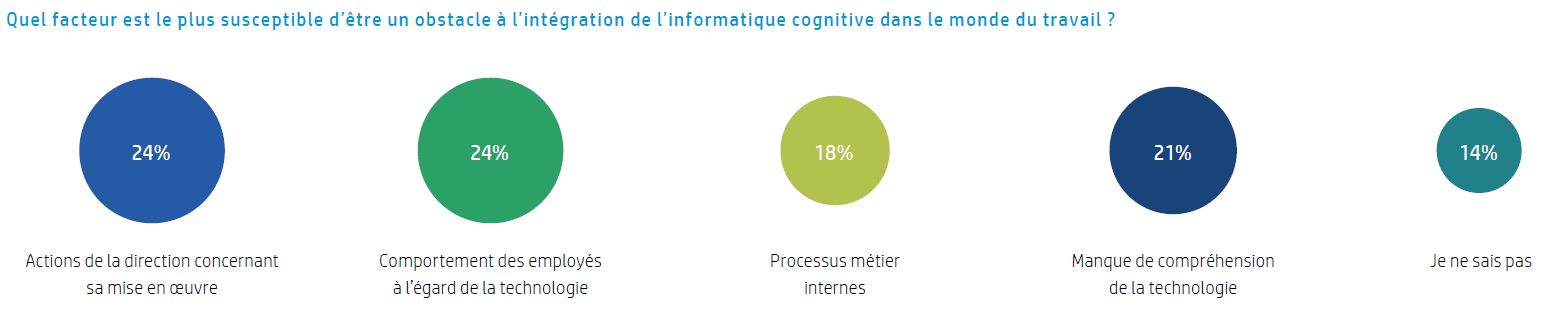

Quels sont les freins à cette technologie ?

Le manque de données n’est probablement pas un problème, bien que 21 % des personnes interrogées croient qu’un manque de compréhension de la technologie est un problème. Dans l’ensemble, près de 50 % des personnes interrogées estiment que la technologie est freinée par les actions de la direction concernant sa mise en oeuvre ou le comportement des employés à son égard. Les raisons sont évidentes.

Premièrement, l’informatique cognitive n’en est encore qu’à ses débuts et les applications pratiques sont plutôt rares. Le coût et les délais de mise en oeuvre de systèmes informatiques cognitifs devront être examinés et planifiés avec soin, en particulier pour les entreprises établies et leurs systèmes existants. Les systèmes cognitifs peuvent-ils multiplier la production et les profits, par exemple ? Existe-t-il des cas d’utilisation ?

Deuxièmement, les entreprises où les processus exigent un personnel important et dont la main-d’oeuvre est en difficulté face au numérique devront suivre un programme de remise à niveau ou d’acquisition de talents, ce qui ne se fera pas rapidement et facilement.

Il est difficile d’établir une feuille de route claire avec des objectifs valables et pourtant réalisables, surtout si cela a un impact sur l’emploi et nécessite de nouvelles compétences. La démystification de l’informatique cognitive et l’amélioration des solutions cloud propres à un secteur déterminé contribueront grandement à rendre cette technologie plus acceptable.

Quelles conclusions pouvons-nous tirer ?

Le taux d’adoption dépendra du marché vertical. Dans le domaine de la santé et de la cybersécurité, par exemple, l’informatique cognitive progresse déjà à grands pas et comme le suggère Howard Roberts, technicien chez HP, “nous sommes au point de basculement de la technologie”.

La capacité de traiter des quantités incroyables de données rendra de plus en plus indispensables des éléments de l’informatique cognitive, tels que le Machine learning. Cette technique d’auto-apprentissage est déjà utilisée dans les systèmes de détection des fraudes et dans le domaine de l’oncologie, et des éditeurs de logiciels de sécurité explorent son potentiel d’utilisation dans des systèmes avancés de détection des programmes malveillants.

“La crainte des employés n’est pas surprenante vu que l’informatique cognitive symbolise pour eux l’automatisation et la suppression de postes”, déclare Roberts, “mais il est vrai qu’on verra une utilisation accrue d’outils cognitifs intégrés dans les systèmes de reconnaissance faciale et d’images, par exemple. Son rythme d’évolution variera en fonction des secteurs d’activité, mais elle est bien présente et a déjà accompli des choses étonnantes. Nous devons simplement veiller à éduquer les utilisateurs et former adéquatement le personnel afin qu’il puisse exploiter au mieux les opportunités que cette technologie créera inévitablement.”

A lire également :

- 6 tendances informatiques prometteuses selon HP

- Edge computing : quel avenir dans le monde de l’entreprise ?

- Expériences immersives : quel avenir dans le monde de l’entreprise ?

- Blockchain : quel avenir dans le monde de l’entreprise ?

- Informatique quantique : quel avenir dans le monde de l’entreprise ?

- Grandes tendances technologiques : quel impact sur l’entreprise ?

- L’Internet des objets (IoT) : Quel avenir dans le monde de l’entreprise ?